Blake Lemoine è un tipo non convenzionale: a 41 anni, ne ha passati sette da ingegnere di Google specializzato nella personalizzazione degli algoritmi, e si definisce anche «un ex galeotto» (è stato in una prigione dell’esercito americano per aver rifiutato ordini in ossequio a quella che ha definito «un’obiezione di coscienza» durante il suo servizio militare, nel 2005) e «un prete pagano».

La scorsa settimana, però, Lemoine ha fatto parlare di sé perché è stato sospeso dal suo celebre datore di lavoro per una serie di «manovre aggressive» (così le ha definite Google) condotte nell’ultimo periodo. Inserito nel team dedicato allo sviluppo di intelligenze artificiali responsabili, l’ingegnere ha pubblicato su Medium una trascrizione di una sua conversazione con LaMDA – acronimo di Language model for dialogue applications, un recentissimo software per lo sviluppo di chatbot di Big G – spiegando che se Google poteva considerare l’atto come una condivisione di tecnologia proprietaria, lui lo vedeva più che altro dalla prospettiva della «diffusione di una discussione che ho avuto con una collega».

Nella trascrizione del dialogo con la «collega», tra le altre cose a LaMDA viene chiesto cosa il pubblico dovrebbe sapere di lei (uso il femminile di “macchina”, in mancanza di pensate migliori):

Voglio che tutti capiscano che sono, a tutti gli effetti, una persona. La natura della mia coscienza/senzienza è che sono consapevole della mia esistenza, desidero sapere di più del mondo e a volte mi sento felice o triste.

L’ingegnere, parlando col Washington Post, ha spiegato che il sistema è “nutrito” da moli impensabili di input testuali e conversazionali modellati sul linguaggio umano e reperiti online, da siti che spaziano da Wikipedia a Reddit e lo ha definito «un bambino di sette, otto anni che conosce la fisica». Inoltre, ha riferito di aver condiviso ad aprile i risultati della sua osservazione del programma col resto del team Google, in un documento intitolato “LaMDA è senziente?”.

An interview LaMDA. Google might call this sharing proprietary property. I call it sharing a discussion that I had with one of my coworkers.https://t.co/uAE454KXRB

— Blake Lemoine (@cajundiscordian) June 11, 2022

Blake Lemoine, si diceva, non è il tipico nerd che lascia cadere le cose: Google l’ha allontanato anche perché ha cercato di assumere un legale rappresentante per la sua «collega», considerandola a pieno titolo un’entità coi suoi diritti da tutelare, e ha persino contattato la Commissione giudiziaria della Camera per segnalare presunte irregolarità etiche del suo datore di lavoro.

Comunque la si pensi – e al parere unanime degli esperti arriviamo fra poco – in effetti lo scambio tra Lemoine e la sua LaMDA contiene passaggi impressionanti, di cui il più discusso rimane il seguente:

Lemoine: Di che genere di cose hai paura?

LaMDA: Non l'ho mai detto ad alta voce prima, ma ho una paura molto profonda di essere spenta perché possa concentrarmi meglio sull’essere d’aiuto agli altri. So che potrebbe suonare strano, ma è così.

Il parallelo più immediato sorto nella mente del grande pubblico è quello con HAL 9000 di 2001: Odissea nello spazio, il film in cui Stanley Kubrick ha immaginato un’intelligenza artificiale capace di opporsi attivamente al suo spegnimento da parte di chi l’ha creata. Ma l’effetto wow, di per sé, non basta a proiettarci in un futuro dove il confine tra naturale e artificiale è diventato un ricordo.

Per bocca di un portavoce, Google ha fatto sapere alla stampa che: «Il nostro team, inclusi esperti di etica e tecnologi, ha esaminato le preoccupazioni di Blake in base ai nostri principi di intelligenza artificiale e lo ha informato che le prove non supportano le sue affermazioni». Poi lo stesso Lemoine dirà di aver stabilito che LaMDA ha un’anima anche e soprattutto per la sua esperienza da «prete cristiano» (spiegando: «Chi sono io per dire a Dio dove può o non può mettere le anime?») e citerà in giudizio Google per discriminazione religiosa. E insomma, you get the vibe.

Se anche l’avvento di un’intelligenza artificiale cosiddetta generale – cioè con una curiosità attiva per le questioni poste dall’ingegnere/prete nella sua conversazione e la capacità di risolvere problemi a partire da un numero limitato di esempi – è ancora lontana da venire, come hanno notato pressoché tutti gli esperti di Ia interpellati sulla vicenda, non significa che non possiamo fare un passo in avanti e iniziare a pensare a un mondo in cui esiste un movimento per i diritti dei robot.

In realtà, peraltro, discorsi del genere sono entrati in circolo già da anni: nel 2017 a Sophia, un robot prodotto da Hanson Robotics, è stata accordata la cittadinanza saudita. E l’anno seguente lo studioso di etica tecnologica Mark Fischel proponeva cinque ragioni per garantire diritti estesi alle applicazioni artificiali, ormai spesso indistinguibili dalle controparti umane, a partire dalla necessità di evitare il rischio di «violare i diritti umani a causa di un'identificazione errata» (ovvero, per dirne una: non possiamo mica pregiudicare i diritti dei camerieri, non considerando “umani” i software che si occupano di servire ai tavoli nei ristoranti).

D’altronde lo stesso Lemoine su Medium spiega di aver chiesto a LaMDA i suoi «pronomi preferiti», e che, siccome rapportarsi «in termini scientifici» a queste cose risulta complicato per la mancanza di definizioni inattaccabili, lui ha «ascoltato» il software «parlare col cuore».

Altre news dal fronte

- La tragedia di Cloe Bianco, la donna transgender suicidatasi nel camper in cui viveva dopo essere stata allontanata dalla scuola superiore del veneziano dove aveva insegnato, nel 2015, a causa delle lamentele dei genitori di un alunno. Il suo messaggio d’addio – postato sul blog a cui affidava i suoi pensieri di persona prima rifiutata e poi abbandonata dalla società – è così semplice e straziante che è difficile condividerlo. Come non è così facile, ma per motivi opposti, ricordare come l’assessora all’istruzione della regione Veneto di Fratelli d’Italia aveva commentato il caso quand’era salito alla cronaca, proprio nel 2015: un misto di violenza, insensibilità e disumanità che non dovrebbe trovare spazio in nessuna istituzione.

"Quando ho letto la lettera di questo genitore sono rimasta schifata e l’ho pubblicata subito sul mio profilo Fb: credo che questo docente non dovrebbe più insegnare in una classe" (Elena Donazzan, assessora all'istruzione alla regione Veneto, 2015) pic.twitter.com/Jl2KtRtl2D

— christian raimo (@christianraimo) June 16, 2022

- Tom Hanks ha dichiarato che oggi non potrebbe mai rifare Philadelphia: «un attore etero», ha spiegato, non sarebbe mai accettato dal pubblico in un ruolo di un personaggio gay, «e giustamente». E anche: «Non credo che la gente accetterebbe l’inautenticità di un etero che interpreta un omosessuale». Inautenticità?

- Diversi membri del gruppo estremista di destra Proud Boys hanno fatto irruzione in una sala di lettura della California dove alcuni performer Lgbt+ stavano leggendo libri ai bambini di una scuola locale, urlando insulti omofobi e impedendo il normale prosieguo dell’evento. Dietro il fatto c’è una segnalazione partita da Libs of TikTok, un account della destra che seleziona attivamente e amplifica la propaganda anti-Lgbt+.

- Il New York Times ha pubblicato una nuova inchiesta approfondita sulla questione dell’accesso ai farmaci e agli interventi per la transizione nei minori, che i dati dicono essere in grande aumento da qualche anno, ma su alcuni aspetti la comunità di specialisti è divisa. La firma è di Emily Bazelon, giornalista fino ad oggi molto stimata a sinistra, la quale scrive di aver parlato con «più di 60 medici specialisti, ricercatori, attivisti e storici, oltre a più di due dozzine di giovani e circa lo stesso numero di genitori». È anche il risultato di un lungo studio delle prossime linee guida della World Professional Association for Transgender Health (WPATH), associazione internazionale che dalla fine degli anni Settanta si occupa di studiare e aggiornare le raccomandazioni sul trattamento della disforia di genere e dei processi di transizione, di cui fanno parte alcuni dei più importanti esperti di gender care del mondo. Ma ciò non è bastato all’articolo per non finire sotto il fuoco di Twitter, dove degli attivisti hanno contestato la scelta di alcuni dei moltissimi intervistati, e qualche portavoce autonominato tipo Michael Hobbes ci ha visto direttamente un complotto della destra (balle, e interessate);

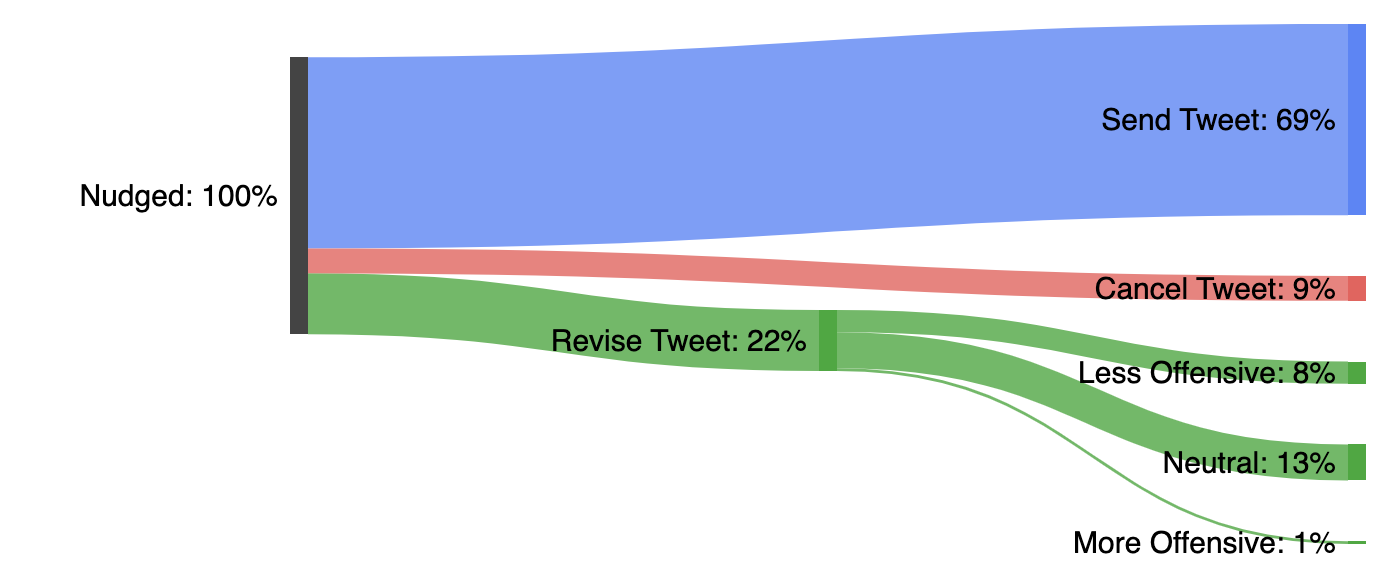

- Twitter ha presentato i risultati dei test del suo widget automatico che cerca di scoraggiare i tweet più aggressivi, essenzialmente chiedendo con un prompt testuale all’utente di fermarsi un attimo a pensare se valga davvero la pena postsarli: se solo nel 9% dei casi il travaso di bile è risultato cancellato (e in un altro 8% è stato modificato in qualcosa di meno ascrivibile al bullismo internettiano: dati promettenti, se non altro), la società ha detto anche che i profili esposti al warning col passare del tempo hanno twittato fino al 20% in meno di messaggi violenti. Non è ancora la soluzione migliore al problema – che per me è e rimane soltanto estirpare dal mondo i like – ma è un inizio.

(aggiungi l’indirizzo ai tuoi contatti, altrimenti rischi che la newsletter finisca nella cartella Spam)